Научный руководитель: Вильданов Алмаз Нафкатович, к.ф.-м.н.

Уфимский университет науки и технологий, Нефтекамский филиал

В условиях информационного бума, когда объемы данных в интернете растут экспоненциально, важное значение приобретает автоматизация сбора и анализа информации. Одной из востребованных задач в этой области является парсинг новостей — процесс извлечения структурированных данных с веб-страниц, содержащих новостные публикации. Парсинг новостей находит применение в аналитике СМИ, мониторинге общественного мнения, финансовых исследованиях, маркетинге и других сферах.

Цель данной работы — рассмотреть современные подходы к парсингу новостей, описать основные инструменты и технологии, а также обсудить практические аспекты реализации систем сбора новостных данных.

1. Методы парсинга новостей

Парсинг (скрапинг) представляет собой автоматическое извлечение данных с веб-страниц. Основными методами сбора новостных данных являются:

Скрапинг HTML-страниц

Данный подход заключается в загрузке HTML-кода страницы и извлечении нужной информации с использованием селекторов (XPath, CSS-селекторы). Для этих целей часто используются библиотеки Python, такие как BeautifulSoup и lxml.

Использование API новостных ресурсов

Некоторые издания предоставляют официальные API для доступа к своим данным. Это наиболее легальный и устойчивый способ получения информации, так как он минимизирует нагрузку на сервер и обеспечивает структурированный формат ответа (обычно JSON).

Использование фреймворков для веб-скрапинга

Фреймворки, такие как Scrapy, позволяют строить масштабируемые проекты по сбору данных. Они обеспечивают гибкость в управлении запросами, обработке ошибок и хранении данных.

Headless-браузеры и Selenium

Для сайтов, где контент подгружается динамически с помощью JavaScript, применяются инструменты, имитирующие поведение пользователя, например Selenium или Playwright.

2. Этапы реализации парсинга новостей

Процесс сбора новостей можно разделить на несколько этапов:

-

Анализ сайта

Изучение структуры сайта, расположения элементов на странице, URL-адресов отдельных новостей.

-

Сбор ссылок на новости

На главной странице или в разделах сайта извлекаются ссылки на отдельные публикации.

-

Извлечение содержимого

Для каждой новости извлекаются заголовок, текст, дата публикации, автор, теги и другие метаданные.

-

Очистка и нормализация данных

Удаление лишних символов, HTML-тегов, приведение даты и времени к единому формату.

-

Хранение данных

Сохранение результатов в виде файлов (CSV, JSON), баз данных (SQLite, PostgreSQL), или передача в системы анализа данных.

3. Проблемы и ограничения

Несмотря на широкие возможности, парсинг новостей сталкивается с рядом трудностей:

Динамический контент – некоторые сайты используют JavaScript для подгрузки информации, что усложняет скрапинг.

Защита от ботов – использование CAPTCHA, IP-ограничений, проверок на активность пользователя.

Изменения структуры сайта – частое обновление дизайна или разметки требует регулярного обновления парсеров.

Правовые и этические аспекты – необходимо соблюдать политику использования данных, указанную в robots.txt и пользовательских соглашениях.

4. Практическое применение

Парсинг новостей широко используется в следующих областях:

Мониторинг общественного мнения – анализ тональности комментариев, выявление трендов.

Финансовый анализ – извлечение новостей о компаниях для прогнозирования изменений на фондовом рынке.

Маркетинговая аналитика – отслеживание упоминаний брендов и продуктов в СМИ.

Научные исследования – сбор корпусов текстов для NLP-задач, лингвистического анализа.

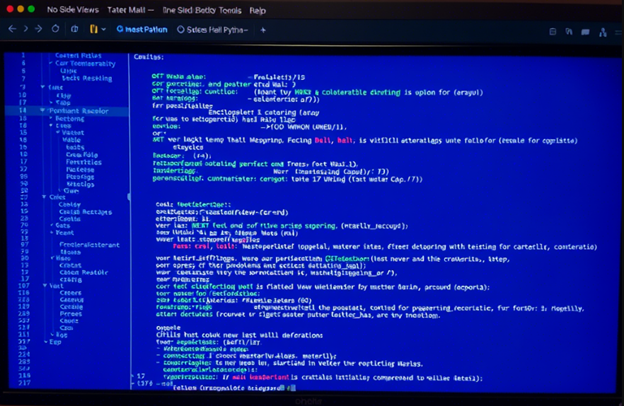

5. Примеры реализации парсинга новостей на Python

Для практической реализации сбора новостных данных язык программирования Python является одним из самых популярных благодаря своей простоте, читаемости кода и наличию мощных библиотек для обработки веб-контента.

5.1. Парсинг новостей с помощью BeautifulSoup и requests

Рассмотрим пример простого парсера, который извлекает заголовки и ссылки на новости с главной страницы одного из новостных сайтов (например, https://example-news-site.com ).

import requests

from bs4 import BeautifulSoup

# URL новостного сайта

url = “https://example-news-site.com “

# Отправляем GET-запрос

response = requests.get(url)

soup = BeautifulSoup(response.text, ‘html.parser’)

# Предположим, что заголовки новостей находятся в тегах <h2> с классом ‘title’

news_items = soup.find_all(‘h2′, class_=’title’)

# Извлекаем заголовки и ссылки

for item in news_items:

title = item.text.strip()

link = item.find(‘a’)['href']

print(f”Заголовок: {title}nСсылка: {link}n{‘-’*30}”)

Этот скрипт отправляет HTTP-запрос к серверу, парсит HTML-ответ и извлекает интересующие элементы.

Примечание : Необходимо адаптировать селекторы под конкретную разметку сайта.

5.2. Сохранение данных в JSON

После извлечения информации её можно сохранить в структурированном виде, например в формате JSON:

import json

# Список новостей

news_data = []

for item in news_items:

title = item.text.strip()

link = item.find(‘a’)['href']

news_data.append({

‘title’: title,

‘link’: link

})

# Сохраняем в файл

with open(‘news.json’, ‘w’, encoding=’utf-8′) as f:

json.dump(news_data, f, ensure_ascii=False, indent=4)

print(“Данные успешно сохранены в news.json”)

Такой подход удобен для последующего анализа или интеграции с другими системами.

5.3. Парсинг динамического контента с Selenium

Если сайт использует JavaScript для отображения контента, можно воспользоваться библиотекой Selenium. Вот пример получения новостей с динамически подгружаемой страницы:

from selenium import webdriver

from bs4 import BeautifulSoup

import time

# Запуск headless-браузера

options = webdriver.ChromeOptions()

options.add_argument(‘–headless’)

driver = webdriver.Chrome(options=options)

# Открытие страницы

driver.get(“https://example-dynamic-site.com “)

time.sleep(5) # Ждём загрузки контента

# Передача HTML в BeautifulSoup

soup = BeautifulSoup(driver.page_source, ‘html.parser’)

titles = soup.find_all(‘h2′, class_=’dynamic-title’)

for title in titles:

print(title.text.strip())

driver.quit()

Этот способ позволяет обходить ограничения статического парсинга.

5.4. Создание паука с помощью Scrapy

Для более масштабных проектов используется фреймворк Scrapy , который предоставляет удобные средства для создания веб-пауков.

Пример простого паука для извлечения новостей:

import scrapy

class NewsSpider(scrapy.Spider):

name = “news_spider”

start_urls = [

'https://example-news-site.com ',

]

def parse(self, response):

for news in response.css(‘div.news-item’):

yield {

‘title’: news.css(‘h2.title::text’).get(),

‘link’: news.css(‘a::attr(href)’).get(),

}

scrapy crawl news_spider -o output.json

Этот способ особенно эффективен при работе с большими объемами данных и множеством страниц.

5.5. Рекомендации по улучшению парсеров

Используйте User-Agent и другие заголовки, чтобы имитировать поведение реального пользователя.

Добавьте задержки между запросами (time.sleep()), чтобы не перегружать сервер.

Обрабатывайте ошибки и исключения с помощью блоков try/except.

Храните данные в базе данных , если требуется долгосрочное хранение и анализ.

Следите за политикой robots.txt сайта, чтобы соблюдать правила использования.

Если вы хотите, я могу также добавить:

Таблицы сравнения библиотек (например, BeautifulSoup vs Scrapy),

Диаграммы архитектуры парсинговой системы,

Примеры обработки текста (NLP),

Подключение к API новостных ресурсов (вроде NewsAPI),

Сравнение производительности разных методов.

Рисунок №1.

Заключение:

Парсинг новостей является важным инструментом для автоматизации сбора информации из открытых источников. Современные технологии позволяют эффективно решать эту задачу, однако успех зависит от правильного выбора инструментов, учета технических и юридических ограничений, а также своевременной адаптации к изменениям в структуре веб-ресурсов. В дальнейшем развитие методов машинного обучения и искусственного интеллекта может повысить точность и автономность систем сбора и анализа новостных данных.

Библиографический список

- Get started with WebGL [Электронный ресурс] / Microsoft. – Электрон. текстовые дан. – Режим доступа: http://msdn.microsoft.com/ruru/Library/dn385807(v=vs.85).aspx, свободный. – Загл. с экрана.

- Three.js – JavaScript 3D library [Электронный ресурс] / Mr.doob. – Электрон. текстовые дан. – Режим доступа: http://threejs.org, свободный. – Загл. с экрана.

- Вильданов А.Н. 3D-моделирование на WebGL с помощью библиотеки Three.js: учебное пособие. – Уфа: РИЦ БашГУ, 2014. – 114 с. – ISBN: 987-5- 7477-3560-6.

- Вильданов, А. Н. Разработка класса Eventcontrols для создания интерактивных трехмерных приложений в web с помощью Three. Js / А. Н. Вильданов // Дневник науки. – 2023. – № 7(79). – DOI 10.51691/2541-8327_2023_7_2. – EDN SSDKQF.